Code

# !pip install dldna[colab] # in Colab

# !pip install dldna[all] # in your local

%load_ext autoreload

%autoreload 2“Wahrnehmung ist nicht ein Fragment einzelner Sinne, sondern eine Symphonie, in der alle Sinne harmonisch verschmelzen.”, James Gibson, Gründer der ökologischen Psychologie.

In der Geschichte der künstlichen Intelligenz gab es lange Zeit ein ungelöstes Problem: die “Multimodalität (Multimodality)”. Menschen nutzen bei der Wahrnehmung der Welt verschiedene Sinnesmodalitäten (Sehen, Hören, Tasten) gleichzeitig und integrieren diese organisch. Zum Beispiel nehmen wir in einem Café gleichzeitig die Wärme der Kaffeetasse (Tastsinn), den Geruch des Kaffees (Gehör), das Gespräch der umstehenden Menschen (Hörsinn) und die Innenausstattung des Cafés (Sehsinn) wahr, um daraus eine ganzheitliche Erfahrung von “im Café sein” zu formen.

Frühe künstliche Intelligenzmodelle hatten jedoch Schwierigkeiten, diese multimodalen Informationen zu verarbeiten. Die seit den 1950er Jahren beginnenden Forschungen zur künstlichen Intelligenz konzentrierten sich vor allem auf die Verarbeitung einzelner Modalitäten (Text, Bilder, Sprache). Es wurden beachtliche Fortschritte in Bereichen wie Übersetzung und Spracherkennung erzielt, aber das Vereinen dieser, um sie wie ein Mensch zu verstehen, stellte eine ganz andere Herausforderung dar.

In diesem Kapitel untersuchen wir die Kerntheorien und überlebenden Architekturen des multimodalen Deep Learnings. Wir werden uns mit der Frage beschäftigen, auf welche Weise jede Architektur das DNA-Strand von Deep Learning erweitert und weiterentwickelt hat und wie sie zur Lösung komplexer Probleme in der realen Welt beitragen.

Herausforderung: Wie kann man Daten verschiedener Arten, wie Text, Bilder und Audio, in einem Modell zusammenfassen und verarbeiten? Diese Daten unterscheiden sich in ihrer Darstellung, Dimensionen und statistischen Eigenschaften. Wie kann man heterogene Informationen fusionieren, um sinnvolle Repräsentationen zu lernen?

Frust der Forscher: Die Forscher mussten neue Methoden finden, die die einzigartigen Eigenschaften jeder Modalität beibehalten und gleichzeitig ihre Interaktionen effektiv modellieren. Es war notwendig, über eine einfache Verkettung (Concatenation) hinauszugehen und echte Fusion zu erreichen, bei der jede Modalität den Kontext der anderen versteht und komplementäre Informationen bereitstellt.

Multimodale Daten beziehen sich auf die Kombination verschiedener Sinnesmodalitäten, wie Text, Bilder und Audio. Das Verstehen von Kaffeeduft und das Hören von Gesprächen sind für Menschen selbstverständlich.

Warum war multimodales Deep Learning ein schwieriges Problem?

Heterogene Datenrepräsentation: Text, Bilder und Audio unterscheiden sich in ihrer Darstellung, Dimensionen und statistischen Eigenschaften. Die effektive Verarbeitung solcher heterogener Daten in einem Modell war eine Herausforderung.

Komplexität der Informationssynthese: Einfache Verkettung (Concatenation) der Informationen jeder Modalität führt nicht zu echter Fusion. Es ist erforderlich, dass jede Modalität den Kontext der anderen versteht, komplementäre Informationen bereitstellt und manchmal widersprüchliche Informationen ausgleicht.

Mangel an Daten und Ungleichgewicht: Multimodale Daten sind im Vergleich zu unimodalen Daten weniger häufig vorhanden, und es gibt ein Ungleichgewicht in den Daten jeder Modalität. Zum Beispiel gibt es viele Paare von Bildern und Texten, aber seltener finden sich Daten, die Bilder, Texte und Audio kombinieren.

Trotz dieser Herausforderungen hat Deep Learning neue Möglichkeiten für die Verarbeitung multimodaler Daten eröffnet. Seit den 2010er Jahren hat die Entwicklung von Deep-Learning-Technologien, insbesondere die Einführung der Transformer-Architektur, eine entscheidende Rolle bei der Fortschritte im Bereich des multimodalen Deep Learnings gespielt. Dies war ein wichtiger Wendepunkt in der Entwicklung der Deep-Learning-DNA. Der Selbst-Aufmerksamkeits-Mechanismus (self-attention) des Transformers ermöglicht es nicht nur, Beziehungen zwischen Elementen innerhalb einer Modalität effektiv zu modellieren, sondern auch komplexe Wechselwirkungen zwischen verschiedenen Modalitäten. Während bis dahin CNNs für Bilder und RNNs für sequenzielle Daten spezialisiert waren, bot der Transformer eine universelle Architektur mit der Flexibilität, auf verschiedene Modalitäten angewendet zu werden.

Multimodales Deep Learning ist eine essentielle Technologie, die es künstlicher Intelligenz ermöglicht, die Welt wie Menschen zu verstehen und mit ihr zu interagieren. Es geht über das einfache Verarbeiten verschiedener Datenformate hinaus und verbindet organisch die Bedeutungen der einzelnen Daten, um reichhaltigere und präzisere Schlussfolgerungen zu ziehen. So wie verschiedene Bereiche des Gehirns zusammenarbeiten, um komplexe kognitive Funktionen auszuführen, ist multimodales Deep Learning die treibende Kraft, die die Intelligenz von KI auf ein höheres Niveau hebt.

Wichtige Anwendungsgebiete

Visuelle Frage-Antwort (Visual Question Answering, VQA): Eingabe von Bildern und Fragen (Text) und Generierung von Antworten auf diese Fragen. Es geht nicht nur darum, Objekte in einem Bild zu erkennen, sondern auch die Bedeutung des Bildes und der Frage umfassend zu verstehen. Zum Beispiel erfordert eine Antwort auf die Frage “Welche Farbe hat der Hut des Mannes im Bild?” den Prozess, den Mann zu finden, den Hut zu erkennen und die Farbe zu bestimmen.

Bildunterschriftenerstellung (Image Captioning): Automatische Erzeugung von Texten zur Beschreibung eines Bildes. Es ist notwendig, den Inhalt des Bildes genau zu erfassen und ihn in eine natürliche Sprache zu übersetzen.

Multimodale Sentimentanalyse: Bestimmung der Stimmung eines Benutzers durch die Kombination von Text, Stimme, Mimik usw. Es ist möglich, ironische Tonlagen oder subtile emotionale Veränderungen, die allein aus dem Text nicht ersichtlich sind, über Änderungen in der Stimmlage oder im Gesichtsausdruck zu erkennen.

Autonome Fahrzeuge: Kombination von Bildern (visuelle Daten), Lidar-Daten, Radar-Informationen und anderen Sensordaten zur sicheren Navigation und Steuerung des Fahrzeugs. Jede Datenquelle bietet einzigartige Informationen, die zusammen eine vollständigere Umgebungswahrnehmung ermöglichen.

Medizinische Diagnostik: Integration von Röntgenbildern, MRIs (Bilder), Patientenakten (Text), biologischen Signalen (zeitliche Daten) und genetischen Informationen zur Diagnose und Vorhersage von Krankheiten. Jede Art von Daten liefert unterschiedliche Hinweise auf eine Krankheit, die zusammen umfassend analysiert werden müssen, um eine präzise Diagnose zu stellen.

Die Forschung zum multimodalen Deep Learning ist eine faszinierende Reise, die die Evolution der Deep-Learning-DNA zeigt. Diese Reise kann in folgende wichtige Phasen unterteilt werden:

In den frühen 2010er Jahren konzentrierten sich die ersten Studien im Bereich des multimodalen Deep Learnings hauptsächlich auf Bildunterschriftenerstellung (image captioning) und VQA (Visual Question Answering). Zu dieser Zeit dominierten CNN-RNN-basierte Modelle, bei denen CNNs (Convolutional Neural Networks) verwendet wurden, um Merkmale aus Bildern zu extrahieren, und RNNs (Recurrent Neural Networks), um Text zu verarbeiten. CNNs waren effektiv darin, räumliche Merkmale von Bildern zu erfassen, während RNNs in der Verarbeitung sequenzieller Informationen stark waren. Aber die frühen Modelle nutzten hauptsächlich das late fusion Verfahren, bei dem jede Modalität unabhängig verarbeitet und die Ergebnisse erst in einem finalen Schritt kombiniert wurden. Diese Methode hatte den Vorteil, dass sie die einzigartigen Eigenschaften jeder Modalität bewahren konnte, jedoch hatte sie die Nachteile, dass sie die Wechselwirkungen zwischen Modalitäten in frühen Phasen nicht ausreichend abbilden konnte.

Einige der bedeutenden Modelle dieser Zeit sind DeViSE (Frome et al., 2013), das Bilder und Wort-Embeddings in den gleichen Raum projiziert, um die Ähnlichkeit zwischen Bildern und Text zu berechnen, und m-RNN (Mao et al., 2014), das CNNs und RNNs kombiniert, um eine Schicht für multimodale Informationssynthese hinzuzufügen.

In der Mitte der 2010er Jahre führte die Einführung des Attention Mechanismus zu einem wichtigen Wendepunkt in der Forschung zum multimodalen Deep Learning. Der Attention Mechanismus ermöglichte es, die Relevanz zwischen Bildern und Text viel präziser zu modellieren. Zum Beispiel erlaubte Attention im Kontext von Bildunterschriften das Lernen, auf welche Bereiche des Bildes beim Erzeugen bestimmter Wörter “geachtet” werden sollte, und bei VQA half es dabei, zu entscheiden, welche Teile eines Bildes betrachtet werden müssen, um eine Frage zu beantworten.

Die Einführung von Attention verbesserte die Leistung von Modellen zur Bildunterschriftenerzeugung und VQA erheblich. Beispiele für bedeutende Modelle sind Show, Attend and Tell (Xu et al., 2015), das Attention einsetzt, um auf Bereiche des Bildes zu fokussieren, die mit den generierten Wörtern relevant sind, und Stacked Attention Networks (Yang et al., 2016), das mehrfach Attention anwendet, um Antworten in VQA aus der Sicht von Fragen zu generieren.

Mit der Einführung der Transformer-Architektur im Jahr 2017 durch den Artikel “Attention is All You Need” erreichte das multimodale Deep Learning eine neue Phase. Der Transformer nutzt das Selbst-Attention-Mechanismus, um die Beziehungen zwischen allen Elementen einer Eingabesequenz direkt zu modellieren.

ViT (Vision Transformer, 2020): Indem ViT Bilder in Patches aufteilt und diese dem Transformer als Eingabe zuführt, ist es zu einem starken Alternativen zu CNNs im Bereich der Bildverarbeitung geworden. ViT modelliert effektiv die langfristigen Abhängigkeiten (long-range dependency) innerhalb von Bildern und zeigt ausgezeichnete Leistungen in verschiedenen Aufgaben wie Bildklassifizierung.

CLIP (Contrastive Language-Image Pre-training, 2021): CLIP lernt, Bilder und Text in den gleichen Raum zu embedden, indem es große Mengen an Bild-Text-Paar-Daten verwendet. Dadurch konnte es ohne zusätzliche Feinabstimmung (fine-tuning) in verschiedenen Downstream-Aufgaben (wie Bildklassifizierung und Objekterkennung) erstaunlich gute Leistungen bei zero-shot-Anwendungen zeigen.

DALL-E (2021), Imagen (2022), Stable Diffusion (2022): Modelle, die hochwertige Bilder basierend auf textbasierten Beschreibungen erzeugen, haben die bemerkenswerte Fähigkeit von Transformer-basierten Generativen Modellen gezeigt. Sie lernen komplexe Beziehungen zwischen Text und Bildern und erzielen Ergebnisse im Bereich der Bilddarstellung, die bislang kaum vorstellbar waren.

GPT-4V (2023), Gemini (2023): Die Einführung großer multimodaler Modelle (LMM, Large Multimodal Model), die Text und Bilder gleichzeitig verstehen und verarbeiten können, hat neue Möglichkeiten für multimodales Deep Learning eröffnet. Diese riesigen Modelle mit Milliarden von Parametern erreichen in verschiedenen multimodalen Aufgaben menschliche Leistungsniveaus und stehen an der Frontlinie der künstlichen Intelligenzforschung.

Die jüngsten Forschungen im Bereich multimodales Deep Learning gehen darüber hinaus, Informationen einfach zu fusionieren. Sie verbessern die Fähigkeit, auf Basis der Informationen aus jeder Modalität neues Wissen zu generieren und zu schließen.

Entwicklung von LMM (Large Multimodal Model): Es erscheinen ständig fortschrittlichere LMM, die mehr Modalitäten (Audio, Video, 3D-Sensordaten usw.) integrieren und komplexere Schließleistungen aufweisen.

Forschung zu effizienten Fusionstechniken: Andererseits wird aktiv an Forschung gearbeitet, um die Effektivität von multimodalen Modellen auch bei begrenzten Rechenressourcen durch Minimierung der Berechnungskosten und Maximierung des Fusionseffekts zu steigern.

Erklärbarkeit (XAI) und ethische Fragen: Mit der Zunahme an Komplexität multimodaler Modelle wird die Bedeutung von Forschungen, die das Verständnis des Entscheidungsprozesses der Modelle fördern und ethische Probleme wie Biased-heit adressieren, größer.

Im nächsten Abschnitt werden wir uns näher mit den frühen Ansätzen im Bereich multimodales Deep Learning und den wichtigen Architekturen, die sich in diesem Prozess durchgesetzt haben, befassen.

Wie in Abschnitt 10.1.3 dargestellt, haben Transformer und CLIP eine Innovation im Bereich des multimodalen Deep Learnings gebracht. Allerdings wurden diese Fortschritte nicht über Nacht erreicht. Schon zuvor gab es zahlreiche Versuche, Bilder und Texte, ja sogar verschiedene Modalitäten miteinander zu kombinieren, und diese frühen Forschungen legten den Grundstein für das moderne multimodale Deep Learning. In diesem Abschnitt werden wir die wichtigsten Ansätze und ihre Bedeutung im frühen Stadium der deep-learning-basierten multimodalen Forschung in den frühen bis mittleren 2010er Jahren untersuchen.

Bildunterschriftgenerierung (Image Captioning) ist die Aufgabe, automatisch einen natürlichsprachlichen Satz (Unterschrift) zu generieren, der ein gegebenes Bild beschreibt. Dies ist ein typisches multimodales Problem, das visuelle Informationen (das Bild) in sprachliche Informationen (den Text) umwandelt und es war einer der Hauptforschungsschwerpunkte im frühen Stadium des deep-learning-basierten multimodalen Deep Learnings. Bildunterschriftgenerierung ähnelt dem Vorgang, bei dem ein kleines Kind ein Bilderbuch betrachtet und sagt: “Hier gibt es einen Hund, und dort gibt es einen Ball!”

In den Anfängen der Bildunterschriftgenerierungsforschung dominierten Modelle, die CNNs und RNNs kombinierten. Es war, als würden zwei Hemisphären eines deep-learning-basierten Gehirns verbunden: ein CNN, das für visuelle Aufgaben zuständig ist, und ein RNN, das für sprachliche Aufgaben verantwortlich ist. Das CNN diente als Bildencoder und extrahierte Merkmalsvektoren aus dem Bild mit Modellen wie VGGNet oder AlexNet, während das RNN als Textdecoder fungierte und Modelle wie LSTM verwendete, um auf Basis der Merkmalsvektoren des Bildes die Unterschriftsatz zu generieren.

Ein repräsentatives Modell ist Show and Tell (Vinyals et al., 2015), welches vorschlug, den durch das CNN extrahierten Bildmerkmalen als Anfangszustand der LSTM-Einheit zu dienen, um die Unterschrift in einem end-to-end-Verfahren zu generieren. Allerdings hatten diese CNN-RNN-Strukturen den Nachteil, dass sie zwar den allgemeinen Inhalt des Bildes gut erfassen konnten, aber die spezifischen Bereiche des Bildes und bestimmte Wörter im Text nicht präzise modellieren konnten.

Der Einführung von Aufmerksamkeitsmechanismen, die bestimmte Bereiche eines Bildes in den Fokus nehmen, folgte eine erhebliche Verbesserung. Dieser Ansatz ermöglichte es Modellen, bei der Generierung jedes Worts einer Unterschrift zu lernen, auf welche Regionen des Bildes sie sich konzentrieren sollten, um genauer und detailliertere Beschreibungen zu produzieren.

Show, Attend and Tell (Xu et al., 2015) war das erste Modell, das den Soft-Aufmerksamkeitsmechanismus in die Bildunterschriftgenerierung einführte. Es lernte bei der Generierung jedes Worts der Unterschrift, welche Regionen des Bildes zu beachten sind, um genauer und detailliertere Beschreibungen zu erstellen.

Ab 2017 kam es zur Einführung von Ansätzen, die sowohl den gesamten Kontext des Bildes (top-down) als auch spezifische Objekte (bottom-up) nutzen. Die bottom-up-Methode verwendet Modelle wie Faster R-CNN, um wichtige Objekte im Bild zu identifizieren, während die top-down-Methode während des Prozesses der Unterschriftgenerierung die Aufmerksamkeitsgewichte dieser Objektmerkmale berechnet.

Das Bottom-Up and Top-Down Attention Modell (Anderson et al., 2018) kombinierte diese beiden Ansätze und führte zu einer erheblichen Verbesserung der Leistung bei der Bildunterschriftgenerierung. Dies ist vergleichbar mit dem Prozess, die allgemeine Handlungslinie eines Geschichtsverlaufs zu berücksichtigen, während man die spezifischen Objekte in jeder Szene detailliert beschreibt.

Bildunterschrift-Forschung hat wichtige Elemente zum Deep-Learning-DNA hinzugefügt. Die Kombination von CNN-RNN bot ein grundlegendes Gerüst, um verschiedene Modalitäten effektiv zu kombinieren, und die Aufmerksamkeitsmechanismen wurden zu einem zentralen Technologieelement im multimodalen Deep Learning. Darüber hinaus hat Bottom-Up and Top-Down Attention die Fähigkeit der Deep-Learning-Modelle zur Bildverstehens auf ein neues Niveau gehoben.

Diese Fortschritte legten den Grundstein für eine Erweiterung über die Bildunterschrift-Erstellung hinaus zu verschiedenen multimodalen Aufgaben wie VQA und multimodal maschinelles Übersetzen. In jüngerer Zeit haben transformer-basierte Modelle wie BLIP das Potenzial gezeigt, nicht nur in der Bildunterschrift-Erstellung, sondern auch in einer Vielzahl von multimodalen Aufgaben gute Leistungen zu erzielen.

BLIP (Bootstrapping Language-Image Pre-training) ist ein transformer-basiertes Modell zur Erstellung von Bildunterschriften. BLIP lernt Bilder und Texte gemeinsam vor, um in der Bildunterschrift-Erstellung sowie bei VQA und Bild-Text-Suche verschiedene multimodale Aufgaben gut zu bewältigen.

Das folgende Beispiel zeigt, wie man mit der Hugging Face Transformers-Bibliothek ein Bilduntertitelung-Modell (BLIP) verwendet.

# !pip install dldna[colab] # in Colab

# !pip install dldna[all] # in your local

%load_ext autoreload

%autoreload 2from transformers import BlipProcessor, BlipForConditionalGeneration

from PIL import Image

import requests

import matplotlib.pyplot as plt

# Load the model and processor

processor = BlipProcessor.from_pretrained("Salesforce/blip-image-captioning-base")

model = BlipForConditionalGeneration.from_pretrained("Salesforce/blip-image-captioning-base")

# Download the image

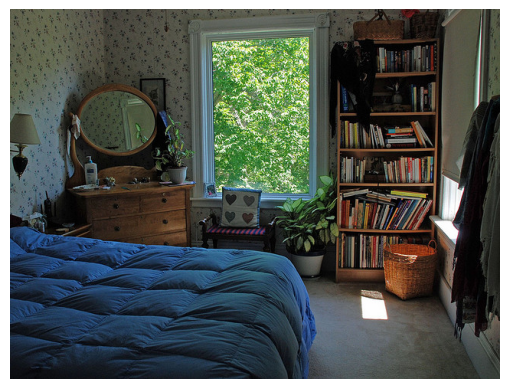

url = "http://images.cocodataset.org/val2017/000000000632.jpg"

image = Image.open(requests.get(url, stream=True).raw)

# Display the image

plt.imshow(image)

plt.axis('off')

plt.show()

# Preprocess the input

inputs = processor(image, return_tensors="pt")

# Generate the caption

outputs = model.generate(**inputs)

# Decode and print the caption

caption = processor.decode(outputs[0], skip_special_tokens=True)

print("Generated caption:", caption)

Generated caption: a bedroom with a bed and a windowVisuelle Frage- und Antwortaufgaben (Visual Question Answering, VQA) beinhalten die Aufgabe, auf einer gegebenen natürlichsprachlichen Frage basierend auf den Inhalt eines Bildes eine Antwort zu generieren. Während Bildbeschreibungen (Image Captioning) sich darauf konzentrieren, den Inhalt eines Bildes zu “beschreiben”, geht es bei VQA darum, mit dem Bild “Fragen und Antworten” zu führen. Ein Beispiel wäre die Beantwortung der Frage: “Was isst die Katze?”. VQA erfordert eine komplexere und anspruchsvollere Fähigkeit zur Verstehens von Bildern als Bildbeschreibungen, insbesondere in Bezug auf das Verständnis und Schließen von Zusammenhängen zwischen Bildern und Fragen (Text).

Ähnlich wie bei Bildbeschreibungen nutzten die frühen VQA-Modelle eine Kombination aus CNNs und RNNS. Dabei wurden mit CNNs die Bildmerkmale extrahiert und mit RNNs die Fragen kodiert, um diese beiden Merkmale zu kombinieren und Antworten zu generieren. Allerdings war es schwierig, komplexe Fragen allein durch das einfache Kombinieren von Bild- und Frage-Merkmalsinformationen zu beantworten.

Nachdem Aufmerksamkeitsmechanismen in der Bildbeschreibung erfolgreich waren, wurden sie auch für VQA eingeführt. Co-Aufmerksamkeit (Co-Attention) wendet Aufmerksamkeit sowohl auf das Bild als auch auf die Frage an, um die Relevanz zwischen den Wörtern der Frage und den Bereichen des Bildes zu berechnen. Dies ermöglicht es, relevante Bereiche des Bildes in Bezug auf die Frage genauer zu identifizieren.

Stacked Attention wiederholt den Aufmerksamkeitsprozess mehrfach, um die komplexen Beziehungen zwischen Bild und Frage schrittweise zu erfassen. Dies ähnelt einem Detektiv, der ein Foto mehrmals überprüft, um die Relevanz für eine Frage allmählich tiefer zu verstehen.

Beispiele für solche Modelle sind Stacked Attention Networks (SAN) (Yang et al., 2016) und Dual Attention Networks (DAN) (Nam et al., 2017). SAN wendet mehrfach Aufmerksamkeit auf das Bild an, um eine Antwort auf die Frage zu generieren, während DAN die Aufmerksamkeit für Bild und Frage getrennt berechnet und diese dann kombiniert, um eine Antwort zu erzeugen.

Ein wesentlicher Unterschied zwischen Bildbeschreibung und VQA ist die Integration externer Kenntnisse. Um die Inferenzfähigkeit von VQA-Modellen weiter zu verbessern, wurden Studien durchgeführt, die externe Kenntnisse (Allgemeinwissen, Enzyklopädiekenntnisse usw.) nutzten. Knowledge Base (KB) ermöglichten es Modellen, auf externen Informationen zurückzugreifen, um Antworten zu generieren. Dies stellte jedoch auch Herausforderungen dar, wie die Relevanz von Kenntnissen und die Komplexität des Inferenzprozesses.

VQA-Forschung hat wichtige Gene zur Deep-Learning-DNA hinzugefügt. Die Kombination von CNNs und RNNs bildet die grundlegende Struktur für die Integration von Bildern und Text, die sie mit Bildbeschreibungen teilt. Multimodale Aufmerksamkeit verlieh Deep-Learning-Modellen die Fähigkeit, komplexe Beziehungen zwischen Bildern und Fragen zu modellieren. Dies bedeutet, dass diese Modelle nicht nur Informationen kombinieren können, sondern auch ihre Wechselwirkung verstehen und daraus Schlussfolgerungen ziehen.

Die Integration externer Kenntnisse öffnete die Möglichkeit, dass Deep-Learning-Modelle durch die Nutzung von externen Wissen zu einem höheren Grad der Inferenz fähig sind. Dies zeigt, dass diese Modelle nicht nur auf Daten angewiesen sind, sondern auch menschliches Wissen und Erfahrung nutzen können. 10.2.1 und 10.2.2 haben gezeigt, dass Bildunterschriftenerstellung (Image Captioning) und Visuelle Fragebeantwortung (VQA) zwei zentrale Aspekte der frühen multimodalen Deep Learning-Forschung waren. Diese Studien leisteten einen bedeutenden Beitrag zur Anwendung und Weiterentwicklung von Kern-Deep-Learning-Technologien wie CNNs, RNNs und Aufmerksamkeitsmechanismen auf multimodale Probleme und bildeten die Grundlage für das Erscheinen noch stärkerer multimodaler Modelle basierend auf dem Transformer (wie CLIP, DALL-E, GPT-4V, Gemini usw.).

In jüngerer Zeit haben sich transformerbasierte VQA-Modelle wie ViLT (Vision-and-Language Transformer) etabliert und gute Leistungen gezeigt. ViLT führt Bild-Patches und Texttokens in dasselbe Transformationsmodell ein, um die komplexen Interaktionen zwischen Bildern und Text effektiv zu modellieren.

ViLT (Vision-and-Language Transformer) ist eines der prominentesten transformerbasierten VQA-Modelle. ViLT führt Bild-Patches und Texttokens in dasselbe Transformationsmodell ein, um die komplexen Interaktionen zwischen Bildern und Text effektiv zu modellieren.

Das folgende Beispielcode zeigt, wie man mit der Hugging Face Transformers-Bibliothek VQA mit dem ViLT-Modell durchführt.

from transformers import ViltProcessor, ViltForQuestionAnswering

from PIL import Image

import requests

import matplotlib.pyplot as plt

# 모델과 프로세서 로드

processor = ViltProcessor.from_pretrained("dandelin/vilt-b32-finetuned-vqa")

model = ViltForQuestionAnswering.from_pretrained("dandelin/vilt-b32-finetuned-vqa")

# 이미지 다운로드

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

# 이미지 출력

plt.imshow(image)

plt.axis('off') # 축 제거

plt.show()

# 질문 설정

question = "How many cats are in the image?"

print("Question:", question)

# 입력 전처리

encoding = processor(image, question, return_tensors="pt")

# 추론

outputs = model(**encoding)

logits = outputs.logits

idx = logits.argmax(-1).item()

print("Predicted answer:", model.config.id2label[idx])

Question: How many cats are in the image?

Predicted answer: 2Angenommen, wir haben zwei Arten von Informationen: Bilder und Text. Wie können diese beiden Informationen kombiniert werden? Die einfachste Methode besteht darin, den Textvektor an den Bildvektor anzuhängen, um einen neuen Vektor zu bilden. Das Verknüpfen von Informationen aus heterogenen Datenquellen wird als Fusion bezeichnet. Die effiziente Fusion von Informationen aus zwei heterogenen Datensätzen ist der Kernpunkt des Multimodalen Lernens. Ein Grund, warum es schwierig sein kann, mit multimodalem Deep Learning zu beginnen, liegt darin, dass es sich um ein sehr schnell wachsendes Feld handelt, in dem eine systematische Zusammenfassung fehlt.

In diesem Abschnitt werde ich die Methoden der Multimodalen Fusion auf Basis des Kurses “Multimodal Machine Learning” von Carnegie Mellon University (CMU) in drei Hauptkategorien unterteilen. Diese Klassifizierung ist zwar nicht standardmäßig im aktuellen multimodalen Forschungsbereich, aber sie ist sehr nützlich für ein systematisches Verständnis der verschiedenen Fusionstechniken.

Joint Representations beziehen sich auf die Darstellung von Daten aus mehreren Modalitäten in einem gemeinsamen Vektorraum (vector space). Es ist, als ob Text und Bild zusammen auf einer Leinwand gezeichnet werden.

Anstatt die Daten jeder Modality getrennt zu verarbeiten, werden sie zu einem integrierten Merkmalsvektor (feature vector) fusioniert. Dieser Vektor fasst die Informationen der Modalitäten zusammen. So kann das Modell tiefere Korrelationen zwischen den Modalitäten lernen. Ein einzelnes Modell kann mehrere Modalitäten verarbeiten, und da die Informationen aus mehreren Modalitäten in einen einzigen Vektor komprimiert werden, ist die Modellstruktur relativ einfach und effizient. Allerdings können die einzigartigen Merkmale jeder Modality während des Fusionierungsprozesses verdünnt oder verloren gehen. Wenn eine bestimmte Modality mehr Informationen als andere enthält, kann dies zu einem Informationsungleichgewicht führen. Darüber hinaus ist es eine sehr schwierige Aufgabe, Daten aus verschiedenen Modalitäten in einen sinnvollen Vektor zusammenzuführen.

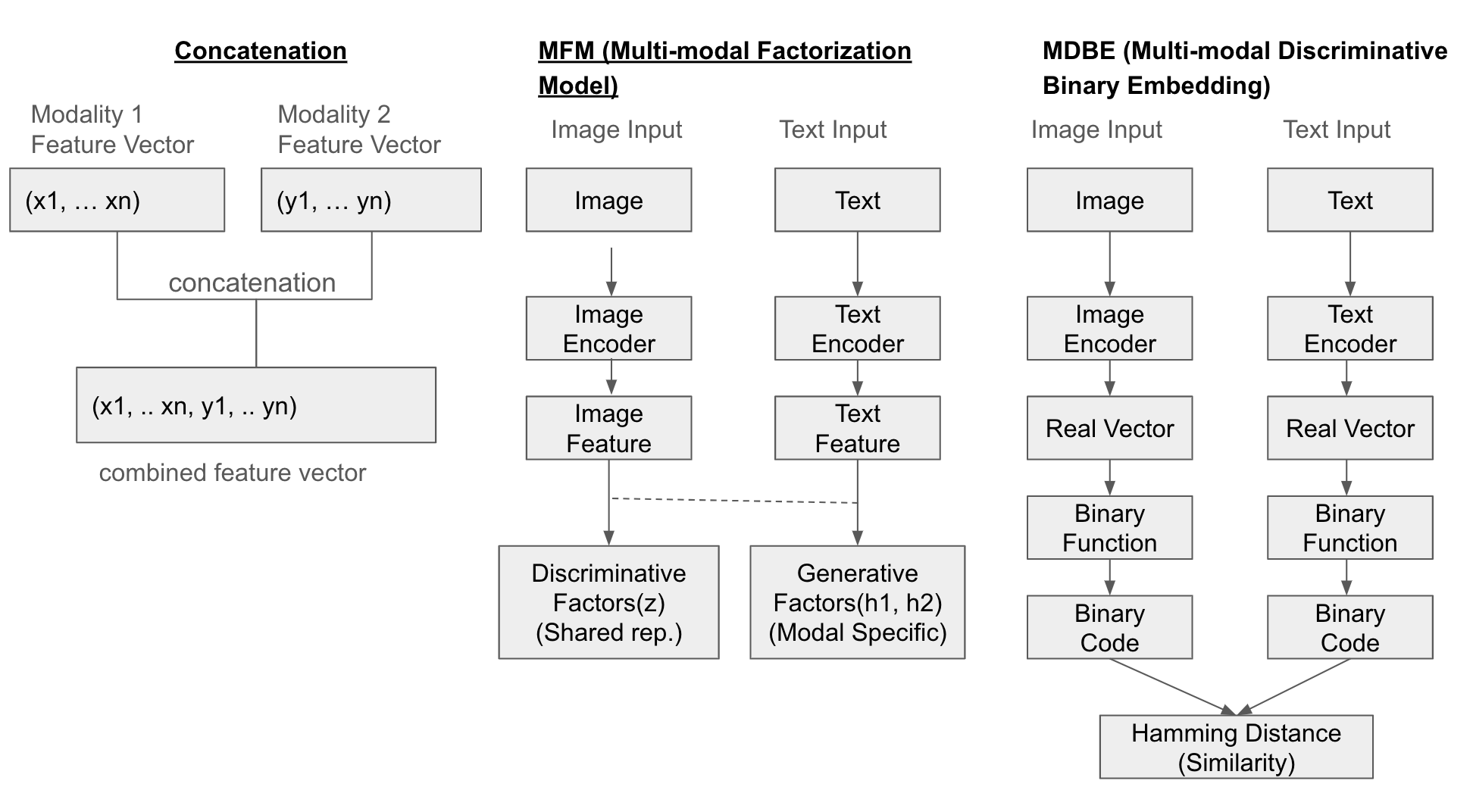

Die einfachste Methode besteht darin, die Merkmalsvektoren jeder Modality direkt anzuhängen (concatenate). Neben dieser gibt es noch das Multi-modal Factorization Model (MFM), das verschiedene Aspekte von Daten durch Matrixfaktorisierung kombiniert, um einen gemeinsamen Darstellungsraum zu erstellen. Das Multi-modal Discriminative Binary Embedding (MDBE) ist eine Methode, die multimodale Daten wie Bilder und Text in binäre Codes übersetzt.

In jüngster Zeit wurden Methoden wie COSA (Concatenated Sample) vorgeschlagen, bei denen mehrere Bild-Text-Paare sequentiell verknüpft werden und ein transformer-basierter Modell angewendet wird, um visuelle Inhalte und zeitliche Anhaltspunkte gemeinsam zu lernen. Zudem verwendet Attentional Concatenation eine mehrstufige Struktur zur Generierung hochauflösender Bilder aus Text, bei der die Ergebnisse von vorherigen Layern als Eingabe für nachfolgende Layern genutzt werden.

Strukturbeschreibung

Die folgende Abbildung veranschaulicht die Fusion in drei Methoden (Concatenation, MFM, MDBF).

Beispiel

from transformers import AutoModel, AutoProcessor, AutoTokenizer

from PIL import Image

import torch

import requests

import matplotlib.pyplot as plt

# Load pre-trained models and processor/tokenizer for image and text

image_model_name = "google/vit-base-patch16-224-in21k" # ViT (Vision Transformer)

text_model_name = "bert-base-uncased" # BERT

image_processor = AutoProcessor.from_pretrained(image_model_name)

image_model = AutoModel.from_pretrained(image_model_name)

tokenizer = AutoTokenizer.from_pretrained(text_model_name)

text_model = AutoModel.from_pretrained(text_model_name)

# Example image and text

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

text = "Two cats sleeping on a couch."

# Display the image

plt.imshow(image)

plt.axis('off') # Remove axes

plt.show()

# Preprocess image and text

image_inputs = image_processor(images=image, return_tensors="pt")

text_inputs = tokenizer(text, return_tensors="pt")

# Feature extraction (embeddings) for each modality

with torch.no_grad(): # Disable gradient calculation (inference mode)

image_features = image_model(**image_inputs).last_hidden_state[:, 0, :] # [CLS] token embedding

text_features = text_model(**text_inputs).last_hidden_state[:, 0, :] # [CLS] token embedding

# Create Joint Representation (Concatenation)

joint_representation = torch.cat((image_features, text_features), dim=1)

print("Image Features Shape:", image_features.shape) # Image feature vector size

print("Text Features Shape:", text_features.shape) # Text feature vector size

print("Joint Representation Shape:", joint_representation.shape) # Combined feature vector size (image + text)Fast image processor class <class 'transformers.models.vit.image_processing_vit_fast.ViTImageProcessorFast'> is available for this model. Using slow image processor class. To use the fast image processor class set `use_fast=True`.

Image Features Shape: torch.Size([1, 768])

Text Features Shape: torch.Size([1, 768])

Joint Representation Shape: torch.Size([1, 1536])Koordinierte Darstellungen sind eine Methode, bei der jede Modalität in einem separaten Raum dargestellt wird, wobei die Beziehungen zwischen ihnen explizit gelernt werden. Es ist ähnlich wie das Zeichnen mehrerer Leinwände so, dass jede Leinwand harmonisch zueinander passt.

Jede Modalität wird durch einen separaten Merkmalsvektor dargestellt, aber diese Vektoren werden so trainiert, dass sie sich gegenseitig “koordinieren”. Das bedeutet, jeder Merkmalsraum der Modalitäten ist unabhängig, aber ihre Ähnlichkeiten, Reihenfolgen und andere Beziehungen werden gelernt, um sinnvolle Verbindungen zwischen ihnen herzustellen. Ein Vorteil dieses Ansatzes besteht darin, dass die einzigartigen Merkmale jeder Modalität maximiert erhalten bleiben, während gleichzeitig ihre Beziehung zu anderen Modalitäten berücksichtigt wird. Darüber hinaus kann er verschiedene Formen von Beziehungen zwischen unterschiedlichen Modalitäten lernen und daher auf eine Vielzahl von multimodalen Problemen angewendet werden.

Allerdings kann die getrennte Verarbeitung jeder Modalität dazu führen, dass die Modellstruktur komplexer wird als bei gemeinsamen Darstellungen. Dies kann das Design und die Training des Modells erschweren. Zudem ist es eine schwierige Aufgabe, die Beziehungen zwischen den verschiedenen Modalitäten explizit zu lernen.

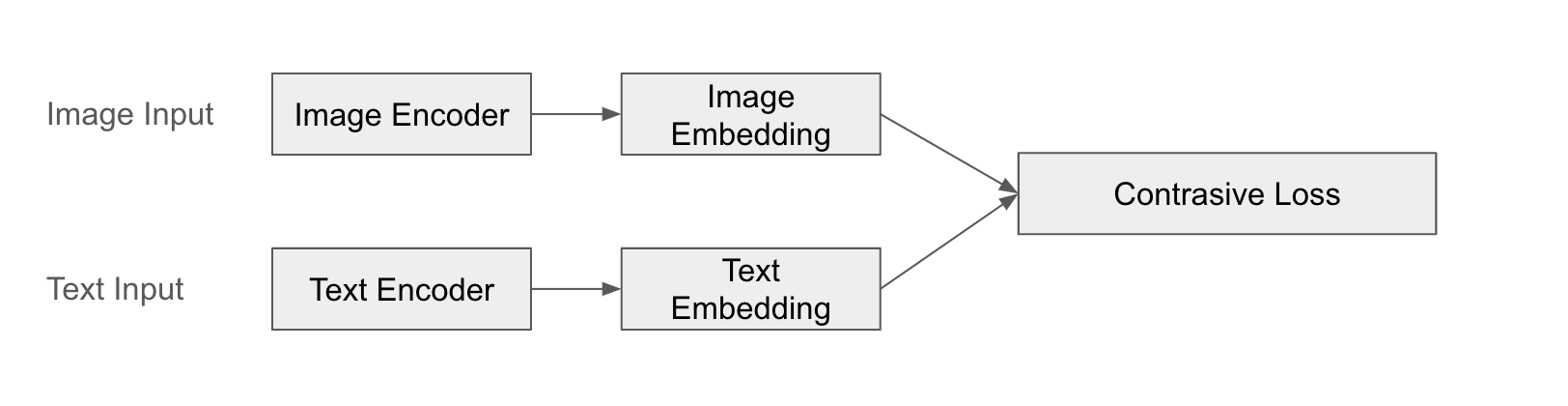

Ein prominentes Beispiel dafür ist CLIP (Contrastive Language-Image Pre-training). CLIP verarbeitet Bilder und Texte jeweils mit separaten Encodern, um Merkmalsvektoren zu erhalten, und lernt dann die Ähnlichkeiten zwischen ihnen. CLIP wird so trainiert, dass Bild und Text “zusammenpassen”, um eine sinnvolle Beziehung zwischen Bild und Text herzustellen.

Der Erfolg von CLIP zeigt sich besonders in der zero-shot Lernfähigkeit. Das vortrainierte CLIP-Modell kann neue Bilder klassifizieren oder suchen, ohne zusätzliche Training für spezifische Aufgaben zu benötigen. Dies ist möglich, weil es die semantischen Verbindungen zwischen Text und Bild effektiv gelernt hat.

Strukturbeispiel

Das folgende Diagramm veranschaulicht die Fusion von CLIP:

Beispiel

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

import torch

import requests

import matplotlib.pyplot as plt

# Load CLIP model and processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Example image and text

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

text = "Two cats sleeping on a couch."

# Display image

plt.imshow(image)

plt.axis('off') # Remove axes

plt.show()

# Preprocess image and text

inputs = processor(text=[text], images=image, return_tensors="pt", padding=True)

# Extract image and text features (embeddings)

with torch.no_grad():

outputs = model(**inputs)

image_features = outputs.image_embeds

text_features = outputs.text_embeds

# Coordinated Representation: Keep features of each modality separate

print("Image Features Shape:", image_features.shape)

print("Text Features Shape:", text_features.shape)

# Calculate similarity between image and text (dot product)

similarity = torch.matmul(image_features, text_features.T) # Or text_features @ image_features.T

print("Image-Text Similarity:", similarity.item())

Image Features Shape: torch.Size([1, 512])

Text Features Shape: torch.Size([1, 512])

Image-Text Similarity: 0.29803216457366943Die obige Methode kann wie folgt angewendet werden, um einen einfachen Zero-Shot-Test durchzuführen.

# Zero-shot 이미지 분류

# - 여러 텍스트 후보군을 만들고, 각 텍스트와 이미지 간의 유사도를 계산하여 가장 높은 유사도를 갖는 텍스트를 선택

candidate_texts = ["a photo of a cat", "a photo of a dog", "a photo of a bird"]

inputs = processor(text=candidate_texts, images=image, return_tensors="pt", padding=True)

with torch.no_grad():

outputs = model(**inputs)

image_features = outputs.image_embeds

text_features = outputs.text_embeds

logits_per_image = outputs.logits_per_image # 유사도 점수

probs = logits_per_image.softmax(dim=1) # 확률

predicted_class_idx = probs.argmax().item()

predicted_class = candidate_texts[predicted_class_idx]

print("Predicted Class:", predicted_class)

print("Probabilities:", probs)Predicted Class: a photo of a cat

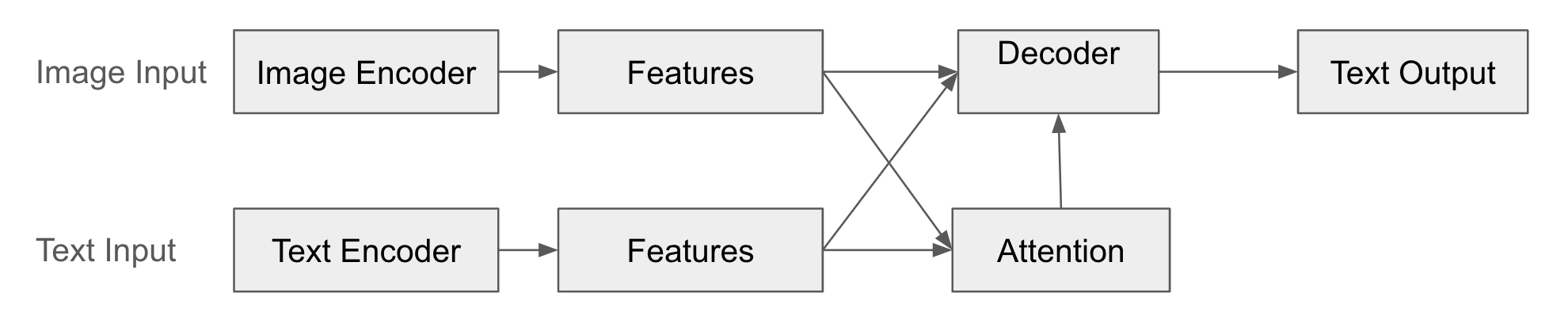

Probabilities: tensor([[9.9403e-01, 5.1377e-03, 8.3070e-04]])Encoder-Decoder ist eine Methode, die Daten einer Modalität in Daten einer anderen Modalität umwandelt. Sie wird häufig bei der Sprachübersetzung verwendet.

In dieser Struktur verwandelt der Encoder (der Eingabepfad) die Daten der Eingangsmodalität (z.B. Bilder) in Merkmalsvektoren. Diese Merkmalsvektoren komprimieren die wesentlichen Informationen der Eingangsdaten. Der Decoder (der Ausgabepfad) generiert auf Basis des von dem Encoder erstellten Merkmalsvektors Daten einer anderen Modalität (z.B. Text). Der Decoder “interpretiert” die Ausgabe des Encoders und erzeugt neue Formate von Daten. Darüber hinaus lernt der Decoder durch den Aufmerksamkeitsmechanismus, auf welche Teile des Merkmalsvektors des Encoders er bei der Generierung der Ausgabedaten “achten” sollte.

Ein Vorteil dieser Methode ist ihre Anwendbarkeit in verschiedenen Aufgaben, die unterschiedliche Formen von Daten verbinden, wie zum Beispiel Bildunterschriftenerstellung, VQA (Visuelle Fragebeantwortung) und maschinelles Übersetzen. Sie kann auch angewendet werden, wenn die Eingangs- und Ausgabemodalitäten sich unterscheiden; verschiedene Kombinationen sind möglich, wie Text-Bild, Bild-Text oder Audio-Text.

Ein typisches Beispiel hierfür sind die Bildunterschriftenerstellung und VQA (Visuelle Fragebeantwortung). Bei der Bildunterschriftenerstellung werden Bilder durch den Encoder verarbeitet, um Merkmalsvektoren zu erhalten, und dann wird ein Decoder verwendet, um eine Bildunterschrift (Text) zu generieren. Bei VQA werden das Bild und die Frage (Text) jeweils durch einen Encoder verarbeitet, und der Aufmerksamkeitsmechanismus wird verwendet, um die Relevanz zwischen dem Bild und der Frage festzustellen; anschließend wird ein Decoder verwendet, um eine Antwort (Text) zu generieren.

Bei langen Eingangs- oder Ausgabedaten kann jedoch Informationsverlust auftreten oder der Berechnungsaufwand zunehmen. Insbesondere bei RNN-basierten Modellen kann das Verschwinden des Gradienten (gradient vanishing problem) es erschweren, langfristige Abhängigkeiten zu lernen. Darüber hinaus muss Encoder und Decoder gleichzeitig trainiert werden, was zu Instabilität oder Schwierigkeiten beim Training führen kann.

Strukturbeispiel

Das folgende Diagramm illustriert die Fusion von Encoder-Decoder.

from transformers import BlipProcessor, BlipForConditionalGeneration

from PIL import Image

import requests

import matplotlib.pyplot as plt

# Load model and processor

processor = BlipProcessor.from_pretrained("Salesforce/blip-image-captioning-base")

model = BlipForConditionalGeneration.from_pretrained("Salesforce/blip-image-captioning-base")

# Download image

url = "http://images.cocodataset.org/val2017/000000000139.jpg"

image = Image.open(requests.get(url, stream=True).raw)

# Display image

plt.imshow(image)

plt.axis('off')

plt.show()

# Input text (optional - Conditional Generation)

# text = "describe this image:" # Prompt (guide image description)

text = "a photo of"

# Preprocess image and text (optional)

# If text is provided, it uses the text as a prompt to generate the caption.

inputs = processor(image, text=text, return_tensors="pt")

# Generate caption

outputs = model.generate(**inputs)

# Decode and print caption

caption = processor.decode(outputs[0], skip_special_tokens=True)

print("Generated caption:", caption)

Generated caption: a photo of a living room with a television and a fireplaceDieses Beispiel zeigt das Bildunterschriftgenerieren, ein typisches Beispiel für die Struktur von Encoder-Decoder. Der Encoder nimmt ein Bild (visueller Encoder von BLIP) als Eingabe und extrahiert Merkmalsvektoren. Der Decoder erzeugt Text (Textdecoder von BLIP). Durch den Aufmerksamkeitsmechanismus wird während der Erstellung der Bildunterschrift bestimmt, auf welche Teile des Merkmalsvektors geachtet werden soll. Man kann Prompts festlegen, die die durch Text generierten Bildunterschriften beeinflussen. BLIP kann sowohl Bilder als auch Text als Eingabe verwenden, hier wird jedoch nur das Bild als Eingabe verwendet und der Text wird vom Decoder erzeugt.

In den Abschnitten 10.3.1, 10.3.2 und 10.3.3 wurden die drei Kerntheorien der multimodalen Fusion, nämlich Gemeinsame Repräsentationen, Koordinierte Repräsentationen und Encoder-Decoder, untersucht. Jede Methode hat ihre eigenen Merkmale und Vor- und Nachteile, daher ist es wichtig, je nach Anwendungsbereich die geeignete Methode auszuwählen.

In der multimodalen Deep Learning ist “Fusion” ein zentrales Verfahren, um Informationen aus verschiedenen Modalitäten zu kombinieren, um reichhaltigere und stärkere Darstellungen zu erstellen. In Abschnitt 10.3 wurde kurz die Fusionstheorie auf der Grundlage von CMU-Vorlesungen betrachtet, aber die tatsächliche multimodale Fusionforschung hat sich viel vielfältiger und dynamischer entwickelt. In dieser Tiefenanalyse werden wir verschiedene Klassifizierungssysteme für Fusion und aktuelle Forschungstrends detailliert analysieren und uns anschauen, welche Technologien im Jahr 2025 in den Fokus geraten.

Die multimodale Fusion kann nicht nur anhand eines einzigen Kriteriums klassifiziert werden. Forscher klassifizieren die Fusionstechniken aus verschiedenen Perspektiven, und jede Klassifizierung ist nicht ausschließlich, sondern ergänzt sich gegenseitig.

Diese Klassifizierung konzentriert sich auf den “Zeitpunkt” in multimodalen Deep Learning-Modellen, zu dem die Fusion stattfindet. (Siehe Abschnitt 10.3.4)

Early Fusion (Frühe Fusion): Die “rohen” Daten (oder sehr früh verarbeiteten Merkmale) jeder Modalität werden auf der Eingabeebene des Modells kombiniert.

Late Fusion (Späte Fusion): Jede Modalität wird durch ein separates Modell verarbeitet, und die Ausgaben der Modelle (z.B. Vorhersageergebnisse) werden in einem letzten Schritt kombiniert.

Hybrid Fusion (Gemischte Fusion): Eine Kombination von Early Fusion und Late Fusion. Die Fusion wird auf verschiedenen Ebenen des Modells durchgeführt, um Informationen auf verschiedenen Ebenen zu nutzen.

Model-Agnostische Fusion: Allgemeine Fusionsmethoden, die nicht von einem bestimmten Modell abhängig sind (Early, Late, Hybrid Fusion usw.).

Modellspezifische Fusion: Fusionsmethoden, die auf spezifischen Modellstrukturen abgestimmt sind.

Neueste Forschung: Bei der CVPR-Workshop (MULA 2025), die am 11. und 12. Juni 2025 stattfinden wird, wird über Modellestrukturen diskutiert, die effektiv verschiedene Sensordaten (Kameras, LiDAR, Radar usw.) im Bereich der autonomen Fahrt integrieren können. Das Ziel dieses Workshops ist es, interdisziplinäre Wechselwirkungen und Kooperationen zwischen den Communities von Computer Vision, Multimedia, Fernerkundung und Robotik zu fördern, wobei insbesondere ein großer Fokus auf multimodale Ansätze im Bereich der autonomen Fahrt gelegt wird.

Symmetrisch (Symmetric) vs. Asymmetrisch (Asymmetric) Fusion:

Symmetrisch: Alle Modalitäten werden gleichwertig behandelt.

Asymmetrisch: Einzelnen Modalitäten wird ein größerer Stellenwert oder andere Rollen zugewiesen.

Neueste Forschung: “Learning Deep Multimodal Feature Representation with Asymmetric Multi-layer Fusion” schlägt einen effektiven Framework vor, um multimodale Merkmale in mehreren Layern innerhalb eines einzelnen Netzwerks zu integrieren. Diese Studie führt zwei Arten von asymmetrischen Fusionsoperationen ein, Channel Shuffle und Pixel Shift, um verschiedene Merkmale abhängig von verschiedenen Fusionsrichtungen zu lernen. Zudem präsentiert “Multimodal sentiment analysis based on multi-layer feature fusion”, das im Januar 2025 veröffentlicht wurde, einen neuen Ansatz für genaue Stimmungsanalyse in Anwesenheit von Modalitätsungleichgewichten und impliziten Ausdrucksbedingungen.

Explizit (Explicit) vs. Implizit (Implicit) Fusion:

Explizit: Beziehungen zwischen Modalitäten werden explizit definiert oder modelliert. (z.B. Aufmerksamkeitsmechanismen)

Implizit: Die Beziehungen zwischen Modalitäten werden nicht direkt definiert, sondern das Modell lernt die Beziehungen durch Lernen selbst zu erkennen. (z.B. einfache Kombination)

Neueste Forschung: Bei der HCI International 2025 Konferenz (Juni 2025) wird eine Studie vorgestellt, die die Vor- und Nachteile von expliziter und impliziter Fusion vergleicht.

Die am meisten beachtete Fusionsmethode in den Forschungen von 2024-2025 ist die aufmerksamkeitsbasierte Mechanismen.

Neueste Forschung

“Bi-Att3DDet”, eine im Januar 2025 veröffentlichte Studie, führt einen bidirektionalen aufmerksamkeitsbasierten Fusionsansatz für die 3D-Objekterkennung bei autonomen Fahrzeugen ein. Diese Forschung schlägt eine bidirektionale Interaktionsmethode vor, um den komplementären Informationsaustausch zwischen LiDAR und Kamerasdaten zu maximieren.

“LANMSFF”, eine Studie, die im März 2024 veröffentlicht und im Februar 2025 überarbeitet wurde, kombiniert ein leichtes aufmerksamkeitsbasiertes Netzwerk mit multi-skalierten Merkmalsfusionen für die Mehrfachansichtsfazialausdruckserkennung. Dieser Ansatz generiert gleichzeitig Channel- und Spatial-Aufmerksamkeitskarten, um wichtige Merkmale hervorzuheben und irrelevante zu unterdrücken.

Neueste Neurowissenschaftsforschungen (2025) untersuchen den Einfluss der Cross-Modalen Kongruenz auf die Verarbeitung und Ablagerung sensorischer Informationen. Diese Studie zeigt, dass die Kongruenz zwischen auditiven und visuellen Reizen eine wichtige Rolle in frühen Stadien der sensorischen Verarbeitung spielt. #### 2.2 Multi-head Attention

Konzept: Durch die Verwendung mehrerer Aufmerksamkeitsköpfe (heads) werden Beziehungen zwischen Modalitäten aus verschiedenen Perspektiven erfasst. Jeder Kopf verwendet unterschiedliche Gewichtsmatrizen (W_Q, W_K, W_V), um die Eingabedaten zu transformieren und die Aufmerksamkeit zu berechnen. Daher kann jeder Kopf sich auf verschiedene Aspekte der Eingabedaten konzentrieren (z.B. Semantik, grammatische Struktur, Stil).

Vorteile: Verschiedene Arten von Beziehungen können gleichzeitig modelliert werden, was das Lernen reichhaltigerer und komplexerer Darstellungen ermöglicht. Zum Beispiel, beim Führen von Bildern und Texten kann ein Kopf sich auf die Beziehung zwischen Objekten in einem Bild und Wörtern im Text konzentrieren, während ein anderer Kopf sich auf die Beziehung zwischen der allgemeinen Stimmung des Bildes und dem Tonfall des Textes fokussiert.

Aktuelle Forschung: Kürzlich haben große multimodale Modelle (LMM) diese Technik weiter ausgebaut und verfeinert, um komplexe Wechselwirkungen zwischen verschiedenen Modalitäten wie Bildern, Texten, Audios und Videos effektiv zu modellieren.

Kontrastives Lernen (Contrastive Learning):

Konzept: Verwandte Modalitätenpaare (z.B. Bild und zugehörige Beschriftung) werden im Einbettungsraum nahe beieinander, unverbundene Paare hingegen weit voneinander entfernt gelernt.

Vorteile: Wirksam auch bei großen Datensätzen ohne Labels, was bei der Lösung von Datenmangelproblemen hilfreich sein kann.

Aktuelle Forschung: “Dual-Level Cross-Modal Contrastive Clustering” (2024) schlägt eine neue Methode des kontrastiven Lernens vor, um die Kluft zwischen visuellen Darstellungen und textueller Bedeutung zu überbrücken.

Maskebasiertes Lernen (Masking-based Learning):

Konzept: Ein Teil der Eingabe wird masiert und das Modell lernt, diese mit Hilfe von Informationen aus einer anderen Modalität wiederherzustellen.

Vorteile: Es kann die gegenseitig komplementären Beziehungen zwischen den Modalitäten lernen. Zum Beispiel, einen Teil eines Bildes zu verdecken und das verdeckte Teil anhand der Textbeschreibung vorherzusagen oder einigen Wörtern in einem Text zu masieren und diese anhand des Bildes vorherzusagen.

Aktuelle Forschung: CAST (2025) hat durch die Masked Node Prediction (MNP)-Prätrainingsstrategie die Ausrichtung von Graphknoten und Texttoken verbessert.

Multimodale Fusion kann auf verschiedene Weisen klassifiziert werden, wobei jede Klassifikation eine andere Perspektive bietet. In der Praxis werden häufig diese Klassifikationen kombiniert verwendet. Zurzeit im Jahr 2025 konzentriert sich die Forschung zur multimodalen Fusion auf die Entwicklung effektiver Fusionstechniken durch das Nutzen von token-basierten feinen Interaktionen, Cross-Attention-Mechanismen und selbstüberwachten Lernmethoden. Insbesondere bei wichtigen wissenschaftlichen Veranstaltungen wie dem CVPR 2025 Workshop (Juni 2025, Nashville) werden aktive Diskussionen über die Fortschritte der multimodalen Fusionstechnologien in verschiedenen Anwendungsbereichen wie autonomes Fahren, medizinische Diagnostik und Materialwissenschaften stattfinden.

Durch diese Deep Dive wird es möglich sein, verschiedene Klassifizierungssysteme der multimodal fusion zu verstehen und die Merkmale jeder Methode zu erkennen, um so eine tiefergehende Analyse der verschiedenen multimodalen Modelle zu ermöglichen, die vorgestellt werden.

Es tut mir leid, aber Sie müssen den zu übersetzenden Koreanischen Text bereitstellen. Bitte geben Sie den Text an, den Sie von Koreanisch ins Deutsche übersetzen lassen möchten.

In den Abschnitten 10.3.1 bis 10.3.3 haben wir uns mit Methoden zur Fusion von multimodalen Daten beschäftigt. Dies ist eine theoretische Klassifikation. Bei der Entwicklung tatsächlicher multimodaler Modelle müssen strategisch welche Fusionsmethode, zu welchem Zeitpunkt und wie sie angewendet wird, anhand der gegebenen Problemstellung und den Eigenschaften der Daten bestimmt werden. In diesem Abschnitt werden wir uns mit fortschrittlichen Modalitätsintegrationsstrategien befassen, die von aktuellen multimodalen Modellen verwendet werden.

Die frühe Fusion kombiniert Eingaben aus mehreren Modalitäten in einem frühen Stadium des Modells. Die einfachste Form besteht darin, die Merkmalsvektoren jeder Modalität zu verketten (concatenate). Der Vorteil der frühen Fusion liegt darin, dass sie es leicht macht, niedrigstufige (low-level) Interaktionen zwischen den Modalitäten zu erfassen. Zum Beispiel, wenn Farben in Bildern und bestimmte Wörter im Text stark miteinander korrelieren, kann die frühe Fusion diese Beziehungen leichter lernen. Allerdings hat sie den Nachteil, dass die Eigenschaften jeder Modalität nicht ausreichend genutzt werden können. Insbesondere, wenn spezialisierte Verarbeitung für jede Modalität erforderlich ist (z.B., CNNs für Bilder und RNNs für Text), kann die frühe Fusion ineffektiv sein.

Neuere Forschungen haben auch Benchmarks vorgestellt, die die Effektivität der frühen Fusion in Umgebungen mit unsicheren multimodalen Daten (noisy data) überprüfen.

Schauen wir uns ein einfaches Beispiel für die frühe Fusion an. Hier wird concatenation zur frühen Fusion innerhalb einer gemeinsamen Repräsentation verwendet. Der gleiche Code wird angewendet. Am Ende wird eine einfache lineare Klassifikation durchgeführt, um zu bestimmen, ob ein Bild eine Katze enthält oder nicht.

from transformers import AutoModel, AutoProcessor, AutoTokenizer

from PIL import Image

import torch

import requests

import matplotlib.pyplot as plt

# 이미지와 텍스트를 위한 사전 학습된 모델 및 프로세서/토크나이저 로드

image_model_name = "google/vit-base-patch16-224-in21k" # ViT (Vision Transformer)

text_model_name = "bert-base-uncased" # BERT

image_processor = AutoProcessor.from_pretrained(image_model_name)

image_model = AutoModel.from_pretrained(image_model_name)

tokenizer = AutoTokenizer.from_pretrained(text_model_name)

text_model = AutoModel.from_pretrained(text_model_name)

# 예제 이미지 및 텍스트

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

text = "Two cats sleeping on a couch."

# 이미지 출력

plt.imshow(image)

plt.axis('off') # 축 제거

plt.show()

# 이미지와 텍스트 전처리

image_inputs = image_processor(images=image, return_tensors="pt")

text_inputs = tokenizer(text, return_tensors="pt")

# 각 모달리티에 대한 특징 추출 (임베딩)

with torch.no_grad(): # 기울기 계산 비활성화 (추론 모드)

image_features = image_model(**image_inputs).last_hidden_state[:, 0, :] # [CLS] 토큰 임베딩

text_features = text_model(**text_inputs).last_hidden_state[:, 0, :] # [CLS] 토큰 임베딩

# Joint Representation 생성 (Concatenation)

joint_representation = torch.cat((image_features, text_features), dim=1)

print("Image Features Shape:", image_features.shape) # 이미지 특징 벡터 크기

print("Text Features Shape:", text_features.shape) # 텍스트 특징 벡터 크기

print("Joint Representation Shape:", joint_representation.shape) # 결합된 특징 벡터 크기 (image + text)

# Joint Representation을 활용한 추가 작업 (예: 분류)

num_labels = 2 # 예: "고양이 없음(0)" "고양이 있음(1)", 두 가지 클래스로 분류

classifier = torch.nn.Linear(joint_representation.size(1), num_labels) # 간단한 선형 분류기

outputs = classifier(joint_representation)

print("Classification Outputs:", outputs)Fast image processor class <class 'transformers.models.vit.image_processing_vit_fast.ViTImageProcessorFast'> is available for this model. Using slow image processor class. To use the fast image processor class set `use_fast=True`.

Image Features Shape: torch.Size([1, 768])

Text Features Shape: torch.Size([1, 768])

Joint Representation Shape: torch.Size([1, 1536])

Classification Outputs: tensor([[0.1817, 0.0355]], grad_fn=<AddmmBackward0>)In dem obigen Beispiel werden Bild und Text direkt mit den Ausgaben separater Modelle namens ViT und BERT kombiniert. Es wird keine zusätzliche Verarbeitung (z.B. Aufmerksamkeit, komplexe Transformationen) der beiden Vektoren durchgeführt, bevor die Bild- und Textmerkmale kombiniert werden. Daher entspricht dies einer frühen Fusion.

Die späte Fusion verarbeitet jede Modalität mit separaten Modellen und kombiniert die Ausgaben der Modelle in einem letzten Schritt (z.B. Vorhersageergebnisse). Der Vorteil dieses Ansatzes besteht darin, dass modalspezifische Modelle verwendet werden können. Zum Beispiel kann ein vorgefertigtes CNN für Bilder und eine vorgefertigte Transformer-Struktur für Texte verwendet werden, um die komplexen Merkmale jeder Modalität effektiv zu extrahieren. Ein Nachteil besteht jedoch darin, dass nur hochstufige (high-level) Interaktionen zwischen den Modalitäten berücksichtigt werden und ein Informationsaustausch in Zwischenschritten schwierig ist.

Die späte Fusion ähnelt Ensemble-Techniken, bei denen die Ausgaben verschiedener modalspezifischer Modelle kombiniert werden, um die Leistung zu verbessern. Dieses Forschungsfeld ist sehr aktiv.

Die hybride Fusion kombiniert Early Fusion und Late Fusion. Die Fusion wird in verschiedenen Schritten des Modells durchgeführt, um Informationen auf verschiedenen Ebenen zu nutzen. Der Vorteil dieses Ansatzes besteht darin, dass sowohl die Vorteile der Early Fusion als auch die der Late Fusion erzielt werden können. Das heißt, sowohl niedrigstufige (low-level) Interaktionen als auch hochstufige Interaktionen zwischen den Modalitäten berücksichtigt werden können. Ein Nachteil besteht jedoch darin, dass die Modellstruktur komplexer wird und viele Hyperparameter angepasst werden müssen.

Ein prominentes Beispiel für hybride Fusion ist die Cross-Modal Attention, bei der Merkmale einer Modalität als Abfrage (query) verwendet werden, um Aufmerksamkeit auf die Merkmale (key-value) der anderen Modalität anzuwenden. Dies ist eine typische Methode zur Durchführung von Fusion in Zwischenschritten.

In jüngsten Forschungen wird neben der Aufmerksamkeit auch Mechanismen wie gated mechanisms und bilinear pooling untersucht, um die Fusion in Zwischenschritten auf verschiedene Weise zu realisieren.

Seit 2023 haben moderne große multimodale Modelle (LMMs) wie Gemini und GPT-4V durch die Einführung von noch raffinierteren Modalitätsintegrationsstrategien ihre Leistung erheblich verbessert.

Das modalspezifische Integrationsverfahren optimiert den Modality-Fusionsansatz anhand der Anforderungen spezifischer Aufgaben. Bei der Bildunterschriftung (Image Captioning) wird der Fokus auf die unidirektionale Transformation von visuellen Informationen in Text gelegt, während bei visueller Frage-Antwort-Interaktion (VQA) bidirektionale Informationsaustausch verstärkt wird.

Diese sophistizierten Integrationsstrategien haben die Leistung multimodaler Modelle erheblich verbessert. Insbesondere ermöglichen sie nicht nur einfache Informationskombination, sondern regeln auch dynamisch die Rolle und Bedeutung jeder Modalität sowie optimieren die Fusionsmethode anhand der Eigenschaften der Aufgabe, was zu herausragenden Ergebnissen in komplexen Inferenzaufgaben führt. Diese Integrationsstrategien erfordern große Datensätze und Rechenressourcen, daher ist es schwierig, sie direkt durch eigene Implementierungen und Experimente zu erlernen. Stattdessen ist es ratsam, konzeptionelle Verständnis durch die Lektüre von Papers und technischen Dokumenten zu den einzelnen Modellen zu gewinnen.

In Abschnitt 10.3 haben wir verschiedene theoretische Methoden und Strategien zur Fusion von multimodalen Daten betrachtet. Auf dieser Grundlage werden wir nun spezifische Techniken untersuchen, wie tatsächliche multimodale Modelle die Informationen jeder Modalität effektiv darstellen und Beziehungen zwischen verschiedenen Modalitäten lernen. Die gesamte Implementierung befindet sich in chapter_10/multimodal_embeding.py.

Eine der Kernaufgaben im multimodalen Lernen besteht darin, verschiedene Modalitäten mit unterschiedlichen Eigenschaften in einen sinnvollen gemeinsamen Raum zu übersetzen. Bilder sind 2D-Arrays von Pixelwerten, Texte sind 1D-Sequenzen von Token und Audio ist eine Reihe von Amplitudenwerten über die Zeit; jede Modalität hat ihre eigene einzigartige Darstellungsweise. Um diese heterogenen Daten effektiv zu verarbeiten, sind Darstellungslern-Techniken erforderlich, die die wesentlichen Eigenschaften jeder Modalität beibehalten und gleichzeitig ihre semantischen Beziehungen erfassen können.

Früher Ansatz: Individuelle Encoder + Projektion

Frühe multimodale Modelle nutzten spezialisierte Encoder für jede Modalität (z.B. CNNs für Bilder, RNNs für Text), um Merkmalsvektoren zu extrahieren und diese dann durch lineare Transformation oder flache MLPs (Multi-Layer Perceptrons) in einen gemeinsamen Vektorraum zu projizieren (siehe Abschnitt 10.3.1: Gemeinsame Darstellung, Konkatenierung).

Neuere Ansätze: Semantische Ausrichtung

In jüngster Zeit dominiert die Methode, Merkmalsvektoren jeder Modalität so zu lernen, dass sie semantisch untereinander “ausgerichtet” sind. D.h., verwandte Bilder und Texte sollten im Einbettungsraum nah beieinander liegen, während unverwandte Bilder und Texte weiter voneinander entfernt sind.

Kontrastives Lernen: (siehe Abschnitt 10.3.2: Koordinierte Darstellung, Beispiel CLIP) Bild-Text-Paare werden als “positive” Beispiele betrachtet, zufällig gemischte Bild-Text-Paare als “negative” Beispiele. Das Lernen erfolgt so, dass die Ähnlichkeit zwischen positiven Beispielen erhöht und die Ähnlichkeit zwischen negativen Beispielen verringert wird.

Tripletten-Loss: Drei Elemente werden verwendet: ein Bild-Anker (anchor), ein positives Textbeispiel (die Caption des Ankerbildes) und ein negatives Textbeispiel (die Caption eines anderen Bildes). Das Lernen erfolgt so, dass der Abstand zwischen dem Ankerbild und dem positiven Text minimiert wird, während der Abstand zwischen dem Ankerbild und dem negativen Text maximiert wird.

Implementierungsbeispiel (Kontrastives Lernen)

class MultimodalEmbedding(nn.Module):

def __init__(self, embedding_dim=512):

super().__init__()

self.image_encoder = models.resnet18(pretrained=True)

self.image_encoder.fc = nn.Sequential(

nn.Linear(512, embedding_dim),

nn.LayerNorm(embedding_dim)

)

self.text_encoder = BertModel.from_pretrained('bert-base-uncased')

self.text_projection = nn.Sequential(

nn.Linear(768, embedding_dim), # BERT output dimension is 768

nn.LayerNorm(embedding_dim)

)

self.logit_scale = nn.Parameter(torch.ones([]) * np.log(1 / 0.07))

def encode_image(self, image):

return self.image_encoder(image)

def encode_text(self, input_ids, attention_mask):

text_features = self.text_encoder(input_ids, attention_mask)[0][:, 0, :] # [CLS] token, keep batch dim

return self.text_projection(text_features)MultimodalEmbedding Klasse:

image_encoder: Verwendet ResNet18, um Bilder in Merkmalsvektoren der Größe embedding_dim zu konvertieren.text_encoder: Verwendet ein BERT-Modell, um Text in Merkmalsvektoren zu konvertieren und durch die text_projection-Schicht auf die Größe embedding_dim anzugleichen.logit_scale: Ein lernbarer Temperaturparameter, wie bei CLIP verwendet.Semantische Ausrichtungsmechanismus

Die semantische Ausrichtung wird hauptsächlich in den folgenden zwei Teilen implementiert: der forward-Methode der Klasse MultimodalEmbedding und constrasive_loss().

def forward(self, image, input_ids, attention_mask):

image_features = self.encode_image(image)

text_features = self.encode_text(input_ids, attention_mask)

image_features = image_features / image_features.norm(dim=-1, keepdim=True)

text_features = text_features / text_features.norm(dim=-1, keepdim=True)

logit_scale = self.logit_scale.exp()

logits = logit_scale * image_features @ text_features.transpose(-1, -2)

# print("logits:", logits.shape)

return logits # Return a single valueforward Methode:

Verwenden Sie encode_image und encode_text, um die Bilder und Texte jeweils zu kodieren.

Merkmalsnormalisierung (Feature Normalization): Durch Anwendung der L2-Normalisierung (L2 normalization) werden die Längen der Vektoren image_features und text_features auf 1 gesetzt. Dies dient dazu, nur die Richtung der Vektoren zu berücksichtigen, um Ähnlichkeiten zu berechnen.

Temperaturkalibrierung (Temperature Scaling): Verwenden Sie logit_scale, um die Verteilung der Ähnlichkeitsbewertungen anzupassen. Wenden Sie die Exponentialfunktion auf logit_scale an, um den Skalierungsfaktor zu erhalten, und multiplizieren Sie diesen mit dem Matrizenprodukt der Bildmerkmalsmatrix und der transponierten Textmerkmalsmatrix. Das Matrizenprodukt berechnet die Skalarprodukte (inner products) zwischen jedem Vektor der Bildmerkmale und allen Vektoren der Textmerkmale, um Ähnlichkeitsbewertungen zu erzeugen.

logits: Berechnen Sie die Ähnlichkeit (Skalarprodukt) zwischen den Vektoren der Bildmerkmale und den Vektoren der Textmerkmale. Verwenden Sie text_features.transpose(-1, -2) anstelle von text_features.t(), um die Transposition durchzuführen. Dies vertauscht die letzten beiden Dimensionen der Textmerkmalsmatrix (Batch, Textmerkmaldimension) zu (Batch, Merkmalsdimension, Text), sodass sie mit der Bildmerkmalsmatrix in Form von (Batch, Bildmerkmaldimension) multipliziert werden kann.

def contrastive_loss(logits): # removed enhanced_similarity

labels = torch.arange(logits.size(0), device=logits.device) # Use logits.size(0)

# Image-to-text and text-to-image contrastive loss

img_txt_loss = nn.CrossEntropyLoss()(logits, labels)

txt_img_loss = nn.CrossEntropyLoss()(logits.T, labels)

# Average loss

return (img_txt_loss + txt_img_loss) / 2In der Funktion contrastive_loss werden die labels als Ganzzahlen von 0 bis (Batchgröße - 1) generiert, um der Größe der logits-Matrix anzupassen. Die diagonalen Elemente (i, i) in der logits-Matrix repräsentieren die Ähnlichkeit zwischen dem i-ten Bild und dem i-ten Text. Daher, da sie die Ähnlichkeit von Bildern und Texten darstellen, die einander entsprechen (positive Paare), werden die Labels so gesetzt, dass diese diagonalen Elemente die korrekten Antworten sind. Darüber hinaus berechnet img_txt_loss den Verlust der Ähnlichkeit von Bild zu Text (image-to-text loss) und txt_img_loss den Verlust der Ähnlichkeit von Text zu Bild (text-to-image loss). Durch das Durchschnittsbilden dieser beiden Verluste wird berücksichtigt, dass sowohl die bidirektionale (image-to-text, text-to-image) semantische Ausrichtung gewahrt bleibt.

Das Mechanismus der semantischen Ausrichtung bildet Merkmale verschiedener Modalitäten in einen semantisch konsistenten Raum ab. Zunächst werden alle Merkmalsvektoren durch L2-Normalisierung auf die Einheitssphäre projiziert, um Skalenunterschiede zwischen den Modalitäten zu eliminieren. Durch Einführung eines Temperatur-skalierenden Parameters wird die Verteilung der Ähnlichkeitswerte angepasst. Eine hohe Temperatur erzeugt eine glattere Verteilung, während eine niedrige Temperatur eine schärfere Verteilung erzeugt, um die Stabilität des Trainings zu erhöhen. Darüber hinaus wird durch kontrastives Lernen gelernt, dass zugehörige Bild-Text-Paare im Embedding-Raum näher und unzugehörige Paare weiter voneinander entfernt sind. Insbesondere werden die Abbildungen von Bild zu Text und von Text zu Bild gleichzeitig optimiert, um eine bidirektionale semantische Ausrichtung zu erzielen.

Ähnlich wie bei CLIPs kontrastivem Lernen werden zugehörige Inhalte näher und unzugehörige Inhalte weiter voneinander entfernt gelernt. Diese Strategie der semantischen Ausrichtung auf Basis des kontrastiven Lernens hat sich seit 2021 mit OpenAIs CLIP entwickelt, gefolgt von Googles PaLM-E, Anthropics Claude und DeepMinds Gemini. Während das ursprüngliche CLIP sich hauptsächlich auf einfaches kontrastives Lernen von Bild-Text-Paaren konzentrierte, erfassen neueste Modelle die gegenseitigen Beziehungen zwischen mehreren Modalitäten noch differenzierter. Insbesondere lernt Gemini die semantische Ausrichtung zwischen verschiedenen Modalitäten wie Bild, Text, Audio und Video gleichzeitig, wobei es die einzigartigen Eigenschaften jeder Modalität beibehält und einen integrierten semantischen Raum erstellt.

Beispiel-Ausführung

Für das Training wird der Datensatz flickr8k verwendet. Mit der Funktion train_multimodal_embedding kann das Modell EnhancedMultimodalEmbedding (oder EnhancedMultimodalEmbedding_no_p) auf dem Flickr8k-Datensatz trainiert werden. In der main-Funktion werden Modell, Datenlader und Optimizer konfiguriert, und durch den Aufruf der Funktion train_multimodal_embedding beginnt das Training.

# download flickr8k.

!mkdir data;cd data;wget "https://github.com/awsaf49/flickr-dataset/releases/download/v1.0/flickr8k.zip";unzip -q flickr8k.zip -d ./flickr8kmkdir: cannot create directory ‘data’: File exists

--2025-03-09 16:33:12-- https://github.com/awsaf49/flickr-dataset/releases/download/v1.0/flickr8k.zip

Resolving github.com (github.com)... 20.200.245.247

Connecting to github.com (github.com)|20.200.245.247|:443... connected.

HTTP request sent, awaiting response... 302 Found

Location: https://objects.githubusercontent.com/github-production-release-asset-2e65be/753516996/d7c62b13-1e50-40ea-8fae-f34a44b1695f?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=releaseassetproduction%2F20250309%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20250309T073156Z&X-Amz-Expires=300&X-Amz-Signature=ff62cf7df8ac3deba8bd6f4f775e164abf03c6d2d6d86d740e5407e52702c6a3&X-Amz-SignedHeaders=host&response-content-disposition=attachment%3B%20filename%3Dflickr8k.zip&response-content-type=application%2Foctet-stream [following]

--2025-03-09 16:33:12-- https://objects.githubusercontent.com/github-production-release-asset-2e65be/753516996/d7c62b13-1e50-40ea-8fae-f34a44b1695f?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=releaseassetproduction%2F20250309%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20250309T073156Z&X-Amz-Expires=300&X-Amz-Signature=ff62cf7df8ac3deba8bd6f4f775e164abf03c6d2d6d86d740e5407e52702c6a3&X-Amz-SignedHeaders=host&response-content-disposition=attachment%3B%20filename%3Dflickr8k.zip&response-content-type=application%2Foctet-stream

Resolving objects.githubusercontent.com (objects.githubusercontent.com)... 185.199.109.133, 185.199.111.133, 185.199.110.133, ...

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.109.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 1112971163 (1.0G) [application/octet-stream]

Saving to: ‘flickr8k.zip’

flickr8k.zip 100%[===================>] 1.04G 56.8MB/s in 19s

2025-03-09 16:33:32 (56.9 MB/s) - ‘flickr8k.zip’ saved [1112971163/1112971163]

import torch

from torchvision import models, transforms

from torch.utils.data import Dataset, DataLoader

# Assuming dldna.chapter_10.multimodal_embedding is in the same directory or Python path.

# Adjust if necessary (e.g., from multimodal_embedding import ...).

from dldna.chapter_10.multimodal_embedding import Flickr8kDataset, MultimodalEmbedding, train_multimodal_embedding, generate_example

# Data transformation setup

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

# Dataset and DataLoader setup

image_dir = './data/flickr8k/Images' # Replace with the actual path to your image directory

caption_file = './data/flickr8k/captions.txt' # Replace with the actual path to your caption file

dataset = Flickr8kDataset(image_dir, caption_file, transform=transform)

train_size = int(0.8 * len(dataset))

val_size = len(dataset) - train_size

train_dataset, val_dataset = torch.utils.data.random_split(dataset, [train_size, val_size])

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True, num_workers=4)

val_loader = DataLoader(val_dataset, batch_size=32, shuffle=False, num_workers=4)

# Model initialization

model = MultimodalEmbedding()

# Model training

train_multimodal_embedding(model, train_loader, val_loader, num_epochs=3)

# Model saving

torch.save(model.state_dict(), 'multimodal_embedding_model.pth')

# Example generation

model_path = 'multimodal_embedding_model.pth'

generate_example(model_path, image_dir, caption_file)Epoch 1/3: 15%|█▍ | 147/1012 [00:16<01:36, 8.96it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 1/3: 100%|██████████| 1012/1012 [01:53<00:00, 8.90it/s]Epoch 1/3 - Train Loss: 0.9618Epoch 1/3 - Validation Loss: 0.5212

Epoch 1: Saved best model with Validation Loss = 0.5212Epoch 2/3: 52%|█████▏ | 525/1012 [00:59<00:55, 8.84it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 2/3: 100%|██████████| 1012/1012 [01:54<00:00, 8.83it/s]Epoch 2/3 - Train Loss: 0.3393Epoch 2/3 - Validation Loss: 0.4240

Epoch 2: Saved best model with Validation Loss = 0.4240Epoch 3/3: 34%|███▍ | 347/1012 [00:39<01:15, 8.85it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 3/3: 100%|██████████| 1012/1012 [01:54<00:00, 8.83it/s]Epoch 3/3 - Train Loss: 0.2313Epoch 3/3 - Validation Loss: 0.3891

Epoch 3: Saved best model with Validation Loss = 0.3891

Image 0:

Top 3 Captions (Image -> Text):

- football players in red congratulate each other as crowds in red cheer behind. (prob: 0.9970)

- a man in black holds up an obama 08 sign. (prob: 0.0023)

- a large group of bicycles racing on the street (prob: 0.0004)

Caption: football players in red congratulate each other as crowds in red cheer behind.

Top 3 Images (Text -> Image):

- Image 0 (prob: 0.9983)

- Image 17 (prob: 0.0013)

- Image 2 (prob: 0.0001)

Kreuzmodaler Aufmerksamkeit wird verwendet, um Beziehungen zwischen verschiedenen Modalitäten effektiv zu modellieren. Dies erweitert die Selbst-Aufmerksamkeit des ViT, um Interaktionen zwischen heterogenen Daten wie Bildern und Text ermöglichen zu können.

Aufmerksamkeitsdesign zwischen den Modalitäten

Kreuzmodaler Aufmerksamkeit verfügt über eine asymmetrische Struktur, die die Eigenschaften jeder Modalität berücksichtigt.

class CrossModalAttention(nn.Module):

def __init__(self, config):

super().__init__()

self.image_proj = nn.Linear(config.image_dim, config.hidden_dim)

self.text_proj = nn.Linear(config.text_dim, config.hidden_dim)

self.attention = nn.MultiheadAttention(config.hidden_dim, config.num_heads)

def forward(self, image_features, text_features):

image_proj = self.image_proj(image_features)

text_proj = self.text_proj(text_features)

attn_output, _ = self.attention(text_proj, image_proj, image_proj)

return attn_outputNach der Projektion von Bild- und Textmerkmalen in einen gemeinsamen latenten Raum lernen wir die Beziehung zwischen den beiden Modalitäten durch ein Multi-Head-Aufmerksamkeitsmechanismus. Dabei werden die Textmerkmale als Abfragen, die Bildmerkmale als Schlüssel und Werte verwendet, um sicherzustellen, dass der Text auf relevante Bereiche des Bildes achtet.

Asymmetrisches Aufmerksamkeitsmuster

Um die eindeutigen Eigenschaften jeder Modalität zu bewahren und dennoch eine effektive Informationsaustausch zu ermöglichen, verwenden wir ein asymmetrisches Aufmerksamkeitsmuster.

class HierarchicalCrossModalAttention(nn.Module):

def __init__(self, config):

super().__init__()

self.local_image_attention = nn.MultiheadAttention(config.hidden_dim, config.num_heads)

self.local_text_attention = nn.MultiheadAttention(config.hidden_dim, config.num_heads)

self.image_to_text_attention = CrossModalAttention(config)

self.text_to_image_attention = CrossModalAttention(config)

self.output_layer = nn.Linear(config.hidden_dim * 2, config.hidden_dim)

def forward(self, image_features, text_features):

local_image = self.local_image_attention(image_features, image_features, image_features)[0]

local_text = self.local_text_attention(text_features, text_features, text_features)[0]

image_attended_text = self.image_to_text_attention(image_features, local_text)

text_attended_image = self.text_to_image_attention(text_features, local_image)

combined_features = torch.cat([image_attended_text, text_attended_image], dim=-1)

output = self.output_layer(combined_features)

return outputHier wird eine bidirektionale Aufmerksamkeit von Bildern zu Text und von Text zu Bildern getrennt durchgeführt. Dies ermöglicht es jeder Modalität, sich selektiv auf relevante Informationen der anderen Modalität zu konzentrieren.

Hierarchische Aufmerksamkeitsstruktur

Um komplexe multimodale Beziehungen zu erfassen, werden mehrere Schichten von Aufmerksamkeit hierarchisch organisiert. In den unteren Schichten werden lokale Merkmale innerhalb jeder Modalität verarbeitet und in den oberen Schichten werden die globalen Beziehungen zwischen den Modalitäten modelliert. Diese hierarchische Struktur spielt eine zentrale Rolle in Modellen wie GPT-4V und Gemini.

class EnhancedMultimodalEmbedding_no_p(MultimodalEmbedding):

def forward(self, image, input_ids, attention_mask):

image_features = self.encode_image(image)

text_features = self.encode_text(input_ids, attention_mask)

image_features = self.image_preserve(image_features)

text_features = self.text_preserve(text_features)

combined_features = self.cross_modal_attention(image_features, text_features)

combined_features = combined_features / combined_features.norm(dim=-1, keepdim=True)

logit_scale = self.logit_scale.exp()

logits = logit_scale * combined_features @ combined_features.t()

return logitsimport torch

from torchvision import models, transforms

from torch.utils.data import Dataset, DataLoader

from collections import namedtuple

from dldna.chapter_10.crossmodal_attention import Flickr8kDataset, CrossModalEmbedding, train_crossmodal_embedding, generate_example

# Configuration

config = namedtuple('Config', ['embedding_dim', 'image_dim', 'text_dim', 'hidden_dim', 'num_heads'])(

embedding_dim=512, # Output embedding dimension

image_dim=512, # ResNet18 image encoder output dimension

text_dim=512, # Text feature (768 from BERT -> 512 after projection)

hidden_dim=512, # Cross-modal attention internal hidden dimension

num_heads=8 # Number of multi-head attention heads

)

# Data transformation setup

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

# Dataset and DataLoader setup

image_dir = './data/flickr8k/Images' # Change to the actual path

caption_file = './data/flickr8k/captions.txt' # Change to the actual path

dataset = Flickr8kDataset(image_dir, caption_file, transform=transform)

train_size = int(0.8 * len(dataset))

val_size = len(dataset) - train_size

train_dataset, val_dataset = torch.utils.data.random_split(dataset, [train_size, val_size])

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True, num_workers=4, pin_memory=True)

val_loader = DataLoader(val_dataset, batch_size=32, shuffle=False, num_workers=4, pin_memory=True)

# Model initialization

model = CrossModalEmbedding(config)

# Model training

train_crossmodal_embedding(model, train_loader, val_loader, num_epochs=3)

# Model saving

torch.save(model.state_dict(), 'crossmodal_embedding_model.pth')Epoch 1/3: 4%|▍ | 40/1012 [00:04<01:41, 9.53it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 1/3: 100%|██████████| 1012/1012 [01:47<00:00, 9.41it/s]Epoch 1/3 - Train Loss: 0.9663Epoch 1/3 - Validation Loss: 0.5378Epoch 2/3: 58%|█████▊ | 582/1012 [01:02<00:45, 9.36it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 2/3: 100%|██████████| 1012/1012 [01:48<00:00, 9.31it/s]Epoch 2/3 - Train Loss: 0.3381Epoch 2/3 - Validation Loss: 0.4452Epoch 3/3: 0%| | 4/1012 [00:00<02:27, 6.82it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 3/3: 100%|██████████| 1012/1012 [01:48<00:00, 9.35it/s]Epoch 3/3 - Train Loss: 0.2288Epoch 3/3 - Validation Loss: 0.3743# Example generation

model_path = 'crossmodal_embedding_model.pth'

generate_example(model_path, image_dir, caption_file)Image 0:

Top 3 Captions (Image -> Text):

- two people walk out onto the desert sand. (prob: 0.9862)

- a man takes a picture of him and his friend with his phone. (prob: 0.0092)

- the little boy wearing the blue shirt is putting dirt in his mouth. (prob: 0.0013)

Caption: two people walk out onto the desert sand.

Top 3 Images (Text -> Image):

- Image 0 (prob: 0.9898)

- Image 2 (prob: 0.0089)

- Image 4 (prob: 0.0005)

Perceiver ist eine multimodale Architektur, die 2021 von DeepMind vorgeschlagen wurde. Sie löst das Problem der quadratischen Komplexität traditioneller Transformer (die Berechnungsaufwand quadratisch mit der Länge des Eingabesequenzes ansteigt) und bietet eine Struktur, die verschiedene Modalitäten (Bilder, Text, Audio, Point Clouds usw.) effektiv verarbeitet. Perceiver ist besonders vorteilhaft, wenn die Größe der Eingangsdaten sehr groß ist (z.B. Hochauflösende Bilder, lange Texte). Hier wird eine allgemeine Beschreibung der Architektur gegeben und Beispiele werden weggelassen. Der Code dient als Beispiel zur Erläuterung.

Kernidee von Perceiver

Perceiver basiert auf den folgenden Ideen:

Perceiver verwendet einen festgelegten Größe des latenten Arrays, unabhängig von der Länge der Eingabesequenz. Dieses latente Array spielt die Rolle, die Informationen der Eingangsdaten zu komprimieren und darzustellen, ähnlich wie ein Flaschenhals große Mengen an Eingangsinformationen in eine kleinere Anzahl von latenten Vektoren zusammenfasst. Daher kann die Anzahl der latenten Vektoren (z.B. 256) festgelegt werden, unabhängig davon, wie groß die Eingangsdaten sind (z.B. 10,000 Tokens), was den Rechenaufwand und den Speicherverbrauch erheblich reduziert.

class Perceiver(nn.Module):

def __init__(self, ..., num_latents=256, latent_dim=512, ...):

super().__init__()

# Latent vector initialization (key!)

self.latents = nn.Parameter(torch.randn(num_latents, latent_dim))

# ...In dem folgenden Code stellt self.latents die latenten Vektoren dar. Es ist als nn.Parameter definiert und somit ein lernfähiger Parameter.

Der Perceiver verwendet keine modalspezifischen Verarbeitungsmethoden (z.B. CNN, RNN) für die Eingabemodalitäten (Bild, Text, Audio usw.). Stattdessen werden die Modalitäten durch einfache Vorverarbeitungsschritte (z.B. Bildpatchs, Texttokenisierung) in eine gemeinsame Form (sequence of vectors) transformiert. Anschließend wird unabhängig von der Modalitätstyp durch dieselbe transformer-basierte Architektur (Cross-Attention, Self-Attention) verarbeitet. Dies ermöglicht es, verschiedene Modalitäten flexibel zu verarbeiten und neue Modalitäten leicht hinzuzufügen.